Few-shot Periodic Video Image Segmentation Based on LSTM and Cross-attention Mechanism

-

摘要:

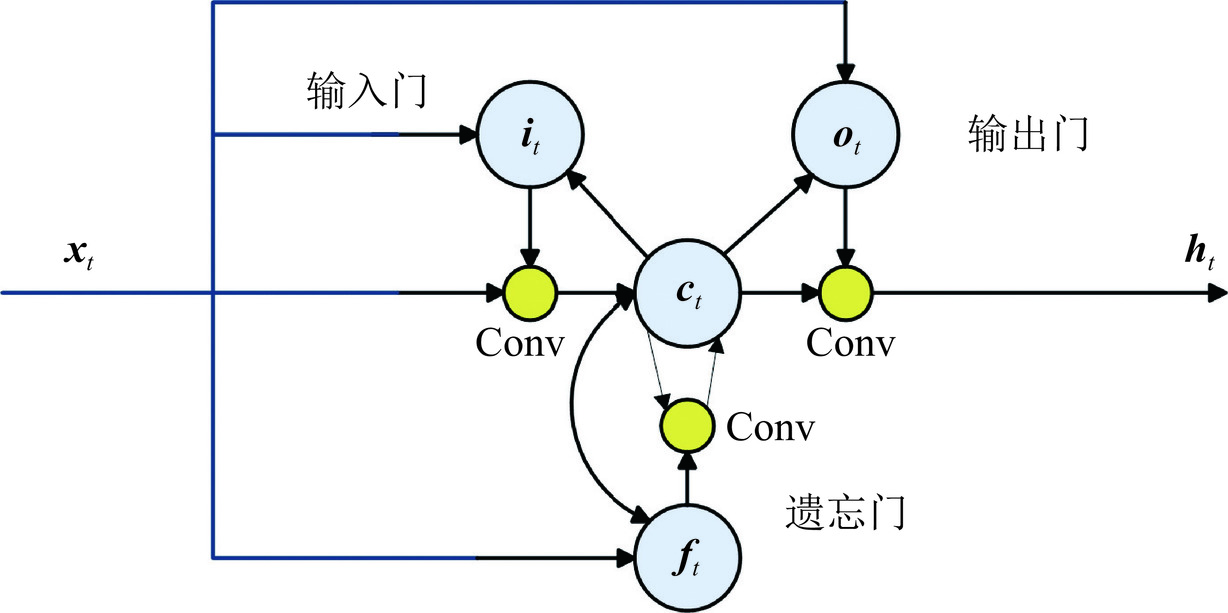

随着现代视频技术的发展,周期运动视频图像分割在运动分析、医学影像等领域中具有重要应用。本文基于深度学习技术设计一种新颖的周期性运动检测和分割网络,结合卷积长短期记忆网络(ConvLSTM)和交叉注意力机制,只需要相对较少的标签,便能够有效捕获视频序列中感兴趣对象的时空上下文信息、跨帧一致性并进行精确分割。实验结果表明,少样本标签情况下,本文方法在周期性运动视频数据集上表现出色。在普通视频中,平均区域相似度和轮廓相似度分别为67.51% 和72.97%,相较于传统方法普遍提升1%~1.5%。在医学视频中,平均区域相似度和轮廓相似度分别为59.93% 和90.56%,在区域相似度上,相较于DAN和Unet分别提升12.92% 和8.85%。在轮廓相似度上,分别提升20.09% 和12.89%,具有更高的准确性和稳定性。

Abstract:With the development of modern video technology, periodic motion video image segmentation has important applications in motion analysis, medical imaging, and other fields. In this study, we designed a novel periodic motion detection and segmentation network based on deep learning technology, which combines the convolutional long short term memory network (ConvLSTM) and cross-attention mechanism. With relatively few labels, we can effectively capture the spatiotemporal context information of the objects of interest in the video sequence, achieving cross-frame consistency and accurate segmentation. Experimental results show that the proposed method performs well on periodic motion video datasets with few sample labels. In an ordinary video, the average region similarity and contour accuracy were 67.51% and 72.97%. respectively, which improved by 1%~1.5% than those obtained with the traditional method. In medical videos, the average region similarity and contour accuracy were 59.93% and 90.56%, respectively. Compared with DAN and Unet, the proposed method increased the regional similarity by 12.92% and 8.85%, whereas it improved the contour accuracy by 20.09% and 12.89%, respectively, thus achieving higher accuracy and stability.

-

Keywords:

- deep learning /

- video segmentation /

- image segmentation /

- LSTM /

- cross-attention mechanism

-

肺癌是全世界最常见的恶性肿瘤之一,在我国肺癌发病率和死亡率均居于首位[1],严重危害我国国民的健康和生命,给家庭和社会带来巨大经济负担。提高肺癌生存率最有效的方法是二级预防,即早发现、早诊断和早治疗,筛查是早期发现肺癌和癌前病变的重要途径[2]。2011年,美国国家肺癌检测试验(National Lung Screening Trial,NLST)首次提出低剂量螺旋计算机断层扫描(low-dose computed tomography,LDCT)检测在高危人群中的应用可显著降低肺癌的死亡率[3],当LDCT上出现异常时可以进一步选择常规CT、高分辨率CT及靶扫描方式对病灶进行甄别。

肺癌的早期常表现为肺部结节病灶,然而肺结节的成因有多种多样,同一对象的CT图像上常有多个肺结节,且表现不一,这对影像诊断医师的筛检和鉴别能力提出了较高的要求。人工智能(artificial intelligence,AI)辅助诊断系统的加入担负了大量枯燥重复的工作,大大提升了影像医师的阅片速度,与医师诊断相比,其具有不受医师的主观性、经验差异及疲劳等人为因素影响的优越性[4]。

鉴于此,本研究回顾性分析113例入组病例的筛检情况来比较AI软件和影像医师的阅片能力,旨在探讨AI辅助诊断系统在肺结节的检测及良恶性判断中的应用价值。

1. 资料与方法

1.1 病例资料

本研究为回顾性研究,选择内蒙古自治区人民医院2022年3月至2023年3月行胸部CT检查,并跟踪随访行CT引导下穿刺活检术或外科手术明确肺结节病理结果的患者作为研究对象。共收集患者113例,其中:男性68例,女性45例。年龄38~77岁,中位约65.20岁。

纳入标准:①在我院至少行 1次胸部CT扫描,并且CT检查前未行干预治疗措施;②符合《肺结节诊治中国专家共识(2018年版)》[5]中肺结节诊断标准且图像质量良好;③涉及结节良恶性判断部分的肺结节均有明确病理诊断。排除标准:①病灶直径>3 cm;②其他部位恶性肿瘤所致转移瘤;③患者患有严重的基础性疾病,无法进行病理诊断;④患者资料信息不完整或失访。

1.2 检查技术

(1)扫描设备:GE LightSpeed750 64排CT;GE LightSpeedVCT 64排CT;西门子Definition Flash 双64排CT;东芝 TSX-301A 320排CT。

(2)扫描范围:扫描前由专人对每位受检者进行呼吸训练,所有受检者均取仰卧位、双臂上举、头先进、深吸气末屏气扫描,扫描范围由肺尖到后肋膈角(包括全部肺)。

(3)扫描参数:管电压120 kV,自动管电流。层间距0.625 mm,层厚1.25 mm,采用标准算法及高分辨算法进行重建并且将扫描原始数据上传至工作站。肺窗参数设置为:肺窗窗宽1500~2000 HU、窗位 -600~-450 HU;纵隔窗宽250~350 HU、窗位30~50 HU。

1.3 图像分析

影像医师阅片。一名住院医师在ImageFileName.dcm工作站上参阅原始图像(1.25 mm层厚)及重建图像(5 mm层厚),阅片过程中常规参考多平面重建技术多角度分析图像,阅片结果由一名临床经验丰富的主治医师审核后发布,以二者报告一致视为有效,否则与另一名主治医师进行探讨后得出最终结论。

AI软件阅片。应用AI辅助分析软件InferRead CTR12.2,由北京推想医疗科技股份有限公司提供。将原始图像导入系统之后,软件自动识别并标记结节病灶,提供结节位置、大小、性质等信息,同时模型根据这些信息计算恶性概率预测值,当恶性概率预测值>70% 时判断为恶性结节。

真阳性结节判断标准。结合两名医师及AI软件图像分析结果,参考多平面重建、三维重建等图像,共同确定肺结节存在,以二者报告一致视为有效。

1.4 数据处理

采用SPSS 25.0软件分析数据,计数资料以(n(%))表示,比较采用卡方检验或Fisher精确概率法,计量资料以

$ \left(\overline{x}\pm s\right) $ 表示。使用Kappa值评价AI、影像医师与病理结果的一致性,0.0~0.20极低的一致性、0.21~0.40一般的一致性、0.41~0.60 中等的一致性、0.61~0.80高度的一致性和0.81~1几乎完全一致。以P<0.01为差异有统计学意义。2. 结果

2.1 总体检出情况

113名患者中,AI软件检出1337个结节,医师检出774个结节,经验证存在1079个真阳性结节。AI软件对于真阳性结节的检出率(98.98%)高于医师(71.27%),漏检率(1.02%)较医师(28.27%)低,误检率(23.91%)较医师(0.46%)高,以上差异均具有统计学意义(表1)。

表 1 AI软件及医师对结节的总体检出情况Table 1. AI software and radiologists’ overall detection of nodules组别 AI 医师 $\chi^2 $ P 共检出(%) 1337(123.91) 774(71.73) 真阳性结节(%) 1068(98.98) 769(71.27) 假阴性结节(%) 11(1.02) 305(28.27) 398.766 <0.001 假阳性结节(%) 258(23.91) 5(0.46) 128.199 <0.001 2.2 AI软件及医师对不同直径真阳性结节的检出价值

AI软件对直径<5 mm及5~10 mm真阳性结节的检出率(98.69%,100.00%)均高于医师(60.59%,80.25%),差异具有统计学意义;对于直径>10 mm真阳性结节的检出率(98.08%)稍高于医师(94.87%),但差异不具有统计意义(表2)。

表 2 AI软件及医师对不同直径真阳性结节的检出价值Table 2. The value of AI software and radiologists in detecting true positive nodules of different diameters组别 真阳性 AI 医师 $\chi^2 $ P <5(%) 609 601(98.69) 369(60.59) 272.521 <0.001 5~10(%) 314 314(100.00) 252(80.25) 68.792 <0.001 >10(%) 156 153(98.08) 148(94.87) 2.356 0.125 2.3 AI软件及医师对不同性质真阳性结节的检出价值

AI软件对磨玻璃、实性、混合磨玻璃及钙化结节的检出率(98.47%,98.79%,100.00%,100.00%)均高于医师(75.52%,68.02%,72.73%,84.66%),差异具有统计学意义(表3)。

表 3 AI软件及医师对不同性质真阳性结节的检出价值Table 3. The value of AI software and radiologists in detecting true positive nodules of different nature组别 真阳性 AI 医师 $\chi^2 $ P 磨玻璃(%) 131 129(98.47) 95(72.52) 35.582 <0.001 实性(%) 741 732(98.79) 504(68.02) 253.375 <0.001 混合磨玻璃(%) 44 44(100.00) 32(72.73) 13.895 <0.001 钙化(%) 163 163(100.00) 138(84.66) 27.076 <0.001 2.4 AI软件及医师对结节良恶性的判断价值

113名患者中共有115个结节经病理检查确诊,其中98例在我院行干预手术或CT引导下穿刺活检取得病理,17例经随访外院诊疗情况确定。

115个结节的大小和性质见表4,AI软件及医师对结节良恶性的判断价值(表5和表6),两种阅片方法对结节良恶性判断的效能比较(表7)。

表 4 115个结节的大小和性质Table 4. Size and nature of the 115 nodules组别 磨玻璃结节个数 实性结节个数 混合磨玻璃结节个数 钙化结节个数 总和 <5 mm 4 9 3 0 16 5~10 mm 6 24 6 1 37 >10 mm 6 41 12 3 62 总和 16 74 21 4 115 表 5 AI软件对结节良恶性的判断价值Table 5. The value of AI software in judging benign and malignant nodulesAI 病理 总计 恶性 良性 恶性 74 12 86 良性 5 24 29 总计 79 36 115 表 6 医师对结节良恶性的判断价值Table 6. The value of radiologists in judging benign and malignant nodulesAI 病理 总计 恶性 良性 恶性 77 7 84 良性 2 29 31 总计 79 36 115 表 7 两种方法对结节良恶性判断的效能比较Table 7. Comparison of efficacy of the two methods in judging benign and malignant nodules组别 灵敏度/% 特异度/% 准确度/% AI 93.67 66.67 85.22 医师 97.47 80.56 92.17 P >0.01 >0.01 <0.01 经SPSS 25.0计算,AI的Kappa一致性是0.637,高度一致;医师的Kappa一致性是0.811,几乎完全一致(P<0.01)。

3. 讨论

本研究对比了AI及影像医师从肺结节的检出到良恶性判断的诊断全过程,真实的反映了AI在实际工作中对于高效诊断的辅助作用,同时该研究在市级三甲医院进行,得到的结果可以大致反映当地的诊疗水平及对新技术的应用程度。

研究结果显示AI软件对真阳性结节的检出率明显高于影像医师,但是误检率较高,与之前研究报道结果基本一致[6-9]。结合误检图像分析,我们考虑是其对于诊断为结节的阈值过低,常将血管、局部增厚的胸膜、肺门淋巴结、肺内索条等饱满结构误认为是肺结节;影像医师的漏检率相对较高,是由于其对于微、小结节的辨识度低,在肺组织背景较杂乱时,难以将肺结节从中检出(图1(a)~图1(c))。医师对于混合磨玻璃结节及钙化结节的检出能力与AI相差不大,但是对于磨玻璃结节和实性结节的检出能力较差,常将边缘欠清晰的磨玻璃结节及较小的实性结节漏检,因此我们应该积极参考AI软件对于不同性质结节的检出结果。

![]() 图 1 部分漏诊及误诊病例影像资料注:(a)右肺下叶血管旁结节,医师检出,AI漏检;(b)右肺下叶胸膜下实性微结节,AI检出,医师漏检;(c) 左侧局部增厚的胸膜,医师检出,AI误检为结节。(d) 右肺上叶实性结节,伴有分叶征,AI及医师均诊断为恶性,病理结果提示错构瘤;(e) 右肺下叶实性结节,形态略欠规整,周围伴有晕征,AI诊断为恶性,医师结合图像及患者痰培养、血象、查体等诊断为良性,病理结果提示肉芽肿;(f)右肺中叶实性结节,有浅分叶和毛刺征象,周围伴有点条状渗出、炎性改变,AI诊断为恶性,医师诊断为良性,病理结果提示浸润性腺癌。Figure 1. Imaging data of some missed and misdiagnosed cases

图 1 部分漏诊及误诊病例影像资料注:(a)右肺下叶血管旁结节,医师检出,AI漏检;(b)右肺下叶胸膜下实性微结节,AI检出,医师漏检;(c) 左侧局部增厚的胸膜,医师检出,AI误检为结节。(d) 右肺上叶实性结节,伴有分叶征,AI及医师均诊断为恶性,病理结果提示错构瘤;(e) 右肺下叶实性结节,形态略欠规整,周围伴有晕征,AI诊断为恶性,医师结合图像及患者痰培养、血象、查体等诊断为良性,病理结果提示肉芽肿;(f)右肺中叶实性结节,有浅分叶和毛刺征象,周围伴有点条状渗出、炎性改变,AI诊断为恶性,医师诊断为良性,病理结果提示浸润性腺癌。Figure 1. Imaging data of some missed and misdiagnosed cases另外,AI软件对于不同直径的肺结节均有很高的检出价值,尤其是在直径小于5 mm及5~10 mm的结节中检出率显著高于医师,但李欣菱等[10]研究认为,AI对较小结节(特别是<5 mm的结节)诊断的临床意义有待商榷,若完全按照AI的结果进行临床干预会增加医疗负担及造成过度治疗。对于直径大于10 mm的肺结节,医师和AI的检出率相近,二者差异不具有统计学意义,刘亚斌等[11]研究得出专业医师 CT扫描对不同直径真阳性结节检出率均低于基于AI技术CT扫描,但专业医师CT扫描对直径>10 mm真阳性结节检出率可达95.12%。提示虽然医师可能会将部分微、小结节漏检,但其对于恶性程度可能较高的直径大于10 mm结节的检出率也高,伴随着较低的误检率,医师对肺结节的检出更灵活、更有意义。

同时本研究就AI软件及医师对于肺结节良恶性的判断效能做出对比,结果显示医师对肺结节良恶性判断的灵敏度、特异度、准确度均较AI高,与既往研究结果基本一致[12-15],但灵敏度和特异度的差异不具有统计学意义,可能与样本选择偏差有关。AI软件的判断结果与病理高度一致,医师的判断结果与病理几乎完全一致。

仔细分析误诊病例(图1(d)~图1(f))后我们考虑AI是根据既定的算法来判断结节的良恶性,无法结合患者的临床信息如肿瘤标记物,特殊病原体培养结果,年龄、性别、工作经历、是否吸烟等个人史,因此得出的结论存在一定的片面性,造成误诊率的上升。影像医师判断的准确性与参加工作时间、学习进修经历和学历等有直接关系,再加上肺结节本身的多变性和复杂性,日常工作中误诊是无法彻底避免的[16]。我们应尽可能提高AI和影像医师甄别同病异影、同影异病的能力,将误诊降到最低,提出对患者更加有利的诊疗方案。

综上所述,AI软件辅助诊断对于肺结节确有较高的检出率,能大大降低漏检率,但误检率也随之上升;在肺结节良恶性鉴别中可为临床诊断提供辅助参考,但其准确性无法取代影像医师。计算机的输出结果是定量分析影像资料获得的,而医生面对的病例却是立体的、变化的。因此在将AI软件作为人工检测辅助手段、代替枯燥工作的同时,影像医师需要不断提升自己的辩证能力,充分结合患者临床信息来提高诊断的特异性,使AI软件更好地为诊断服务;且影像医师最能知道如何将来自互补成像技术的信息与临床数据相结合,这对软件的设计开发及数据库扩展至关重要。

本研究还存在局限性,这项回顾性研究的病理结果已经在临床诊断和治疗中得到确认,因此样本选择方面会存在偏差,这些偏差将在后续的前瞻性试验中得到校正;由于试验样本量较小、设备无法统一及对部分病例失访等问题。我们得到的结论还亟待在更多地区、更多医院的大样本中进一步验证。

-

表 1 各模型的显存使用

Table 1 Memory use of each model

模型 显存/Gbits ResNet 4.83 ConvLSTM 4.46 DAN 6.22 Ours 6.27 表 2 各模型在3图像组上的性能对比

Table 2 Performance comparison of each model on 3 image groups

模型 J F ResNet 0.553 0.592 ConvLSTM 0.530 0.569 DAN 0.637 0.687 Ours 0.642 0.691 表 3 各模型在5图像组上的性能对比

Table 3 Performance comparison of ecah model on 5 image groups

模型 J F ResNet 0.555 0.605 ConvLSTM 0.551 0.599 DAN 0.665 0.715 Ours 0.675 0.730 表 4 各模型在周期与非周期数据上性能对比

Table 4 Performance comparison of each models on periodic and aperiodic data

数据 模型 J F 非周期 DAN 0.680 0.728 非周期 Ours 0.671 0.719 周期 DAN 0.665 0.715 周期 Ours 0.675 0.730 表 5 各模型鸡胚胎分割性能对比

Table 5 Comparison of chicken embryo partitioning of each models

模型 J F DAN+ResNet 0.140 0.075 LCA+ResNet 0.331 0.252 Unet 0.511 0.777 DAN+Unet 0.470 0.705 LCA+Unet 0.599 0.906 -

[1] BROX T, MALIK J. Object segmentation by long term analysis of point trajectories[C]//European conference on computer vision. Berlin, Heidelberg: Springer Berlin Heidelberg, 2010: 282-295. DOI: 10.1007/978-3-642-15555-0_21.

[2] LEE Y J, KIM J, GRAUMAN K. Key-segments for video object segmentation[C]//2011 International Conference on Computer Vision. IEEE, 2011: 1995-2002. DOI: 10.1109/iccv.2011.6126471.

[3] WANG W, SHEN J, PORIKLI F. Saliency-aware geodesic video object segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2015: 3395-3402. DOI: 10.1109/cvpr.2015.7298961.

[4] DUTT J S, XIONG B, GRAUMAN K. Fusionseg: Learning to combine motion and appearance for fully automatic segmentation of generic objects in videos[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017: 3664-3673. DOI: 10.1109/cvpr.2017.228.

[5] LI S, SEYBOLD B, VOROBYOV A, et al. Instance embedding transfer to unsupervised video object segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2018: 6526-6535. DOI: 10.1109/cvpr.2018.00683.

[6] LU X, WANG W, MA C, et al. See more, know more: Unsupervised video object segmentation with co-attention siamese networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2019: 3623-3632. DOI: 10.1109/cvpr.2019.00374.

[7] 许欣. 无监督学习的视频多目标分割算法研究[D]. 徐州: 中国矿业大学, 2021. DOI: 10.27623/d.cnki.gzkyu.2021.001191. [8] 成华阳. 基于高效深度学习的实时无监督视频目标分割算法研究[D]. 成都: 电子科技大学, 2022. DOI: 10.27005/d.cnki.gdzku.2022.002787. [9] CAELLES S, MANINIS K K, PONT-TUSET J, et al. One-shot video object segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017: 221-230. DOI: 10.1109/mmsp.2019.8901723.

[10] TOKMAKOV P, ALAHARI K, SCHMID C. Learning video object segmentation with visual memory[C]//Proceedings of the IEEE International Conference on Computer Vision, 2017: 4481-4490. DOI: 10.1109/iccv.2017.480.

[11] CI H, WANG C, WANG Y. Video object segmentation by learning location-sensitive embeddings[C]//Proceedings of the European Conference on Computer Vision (ECCV), 2018: 501-516. DOI: 10.1007/978-3-030-01252-6_31.

[12] OH S W, LEE J Y, XU N, et al. Video object segmentation using space-time memory networks[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision,2019: 9226-9235. DOI: 10.1109/iccv.2019.00932.

[13] 陈亚当, 赵翊冰, 吴恩华. 基于动态嵌入特征的鲁棒半监督视频目标分割[J]. 北京航空航天大学学报. DOI: 10.13700/j.bh.1001-5965.2023.0354. CHEN Y D, ZHAO Y B, WU E H. Robust semi-supervised video object segmentation with dynamic embedding[J]. Journal of Beijing University of Aeronautics and Astronautics. DOI:10.13700/j.bh.1001-5965.2023.0354. (in Chinese).

[14] 付利华, 赵宇, 姜涵煦, 等. 基于前景感知视觉注意的半监督视频目标分割[J]. 电子学报, 2022, 50(1): 195-206. DOI: 10.12263/DZXB.20201256. FU L H , ZHAO Y , JIANG H X , et al. Semi-Supervised video object segmentation based on foreground perception visual attention[J]. Acta Electonica Sinica, 2022, 50(1): 195-206. DOI:10.12263/DZXB.20201256. (in Chinese).

[15] 李兰. 基于深度学习的半监督视频目标分割方法研究[D]. 成都: 电子科技大学, 2023. DOI: 10.27005/d.cnki.gdzku.2023.001778. [16] OH S W, LEE J Y, XU N, et al. Fast user-guided video object segmentation by interaction-and-propagation networks[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2019: 5247-5256. DOI: 10.1109/cvpr.2019.00539.

[17] HEO Y, JUN KOH Y, KIM C S. Interactive video object segmentation using global and local transfer modules[C]//Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, 2020, Proceedings, Part XVII 16. Springer International Publishing, 2020: 297-313. DOI: 10.1007/978-3-030-58520-4_18.

[18] KHOREVA A, ROHRBACH A, SCHIELE B. Video object segmentation with referring expressions[C]//Computer Vision-ECCV Workshops. Munich, Germany, 2018, Proceedings Part Ⅳ. 2018: 7-12. DOI: 10.1007/978-3-030-11018-5_2.

[19] SEO S, LEE J Y, HAN B. Urvos: Unified referring video object segmentation network with a large-scale benchmark[C]//Computer Vision–ECCV 2020: 16th European Conference, Glasgow, UK, 2020, Proceedings, Part XV 16. Springer International Publishing, 2020: 208-223. DOI: 10.1007/978-3-030-58555-6_13.

[20] SIAM M, DORAISWAMY N, ORESHKIN B N, et al. Weakly supervised few-shot object segmentation using co-attention with visual and semantic embeddings[J]. Arxiv Preprint Arxiv: 2001.09540, 2020. DOI: 10.24963/ijcai.2020/120.

[21] 唐子淑, 刘杰, 别术林. 基于CV模型的CT图像分割研究[J]. CT理论与应用研究, 2014, 23(2): 193-202. TANG Z S, LIU J, BIE S L. Study of CT image segmentation based on CV model[J]. CT Theory and Applications, 2014, 23(2): 193-202. (in Chinese).

[22] 周茂, 曾凯, 杨奎, 等. 肺部CT图像分割方法研究[J]. CT理论与应用研究, 2018, 27(6): 683-691. DOI: 10.15953/j.1004-4140.2018.27.06.01. ZHOU M, CENG K, YANG K, et al. Research of lung segmentation based on CT image[J]. CT Theory and Applications, 2018, 27(6): 683-691. DOI: 10.15953/j.1004-4140.2018.27.06.01. (in Chinese).

[23] 邵叶秦, 杨新. 基于随机森林的CT前列腺分割[J]. CT理论与应用研究, 2015, 24(5): 647-655. DOI: 10.15953/j.1004-4140.2015.24.05.02. SHAO Y Q, YANG X. CT prostate segmentation based on random forest[J]. CT Theory and Applications, 2015, 24(5): 647-655. DOI: 10.15953/j.1004-4140.2015.24.05.02. (in Chinese).

[24] 杨昌俊, 杨新. 基于图割与快速水平集的腹部CT图像分割[J]. CT理论与应用研究, 2011, 20(3): 291-300. YANG C J, YANG X. Abdominal CT image segmentation based on graph cuts and fast level set[J]. CT Theory and Applications, 2011, 20(3): 291-300. (in Chinese).

[25] BELLO I, ZOPH B, VASWANI A, et al. Attention augmented convolutional networks[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2019: 3286-3295. DOI:10.1109/iccv.2019.00338. (in Chinese).

[26] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[J]. Advances in Neural Information Processing Systems, 2012, 25. DOI: 10.1145/3065386

[27] HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780. DOI: 10.1162/neco.1997.9.8.1735.

[28] VASWANI A, SHAZEER N, PARMAR N, et al. Attention is all you need[J]. Advances in Neural Information Processing Systems, 2017, 30. DOI: 10.48550/arXiv.1706.03762.

[29] PARMAR N, VASWANI A, USZKOREIT J, et al. Image transformer[C]//International Conference on Machine Learning. PMLR, 2018: 4055-4064. DOI: 10.48550/arXiv.1802.05751.

[30] HOU R, CHANG H, MA B, et al. Cross attention network for few-shot classification[J]. Advances in Neural Information Processing Systems, 2019, 32. DOI: 10.48550/arXiv.1910.07677.

[31] DEVLIN J, CHANG M W, LEE K, et al. Bert: Pre-training of deep bidirectional transformers for language understanding[J]. Arxiv Preprint Arxiv: 1810.04805, 2018. DOI: 10.18653/v1/N19-1423.

[32] BELLO I, ZOPH B, VASWANI A, et al. Attention augmented convolutional networks[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision. 2019: 3286-3295. DOI: 10.1109/ICCV.2019.00338.

[33] ZHANG C, LIN G, LIU F, et al. Canet: Class-agnostic segmentation networks with iterative refinement and attentive few-shot learning[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 5217-5226. DOI: 10.1016/j.patcog.2021.108468.

[34] DENG J, DONG W, SOCHER R, et al. Imagenet: A large-scale hierarchical image database[C]//2009 IEEE Conference on Computer Vision and Pattern Recognition. IEEE, 2009: 248-255. DOI: 10.1109/cvpr.2009.5206848.

[35] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2016: 770-778. DOI: 10.1109/cvpr.2016.90

[36] CHEN H, WU H, ZHAO N, et al. Delving deep into many-to-many attention for few-shot video object segmentation[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 14040-14049. DOI: 10.1109/cvpr46437.2021.01382.

[37] ZHAO C, SHI S, HE Z, et al. Spatial-temporal V-Net for automatic segmentation and quantification of right ventricle on gated myocardial perfusion SPECT images[J]. Medical Physics, 2023, 50(12): 7415-7426. DOI: 10.1002/mp.16805.

[38] RONNEBERGER O, FISCHER P, BROX T. U-net: Convolutional networks for biomedical image segmentation[C]//Medical Image Computing and Computer-assisted Intervention-MICCAI 2015: 18th International Conference, Munich, Germany, October 5-9, 2015, Proceedings, Part III 18. Springer International Publishing, 2015: 234-241. DOI: 10.1007/978-3-319-24574-4_28.

-

期刊类型引用(4)

1. 张彩云,韩志海. 2024年版肺结节诊治中国专家共识解读. 河北医科大学学报. 2025(04): 373-378 .  百度学术

百度学术

2. 王皓,白卓杰. 基于CT的人工智能技术在肺结节诊断中的应用进展. 中国临床研究. 2025(05): 667-671+676 .  百度学术

百度学术

3. 刘洋,孙旭,王涟. 国内医疗健康领域人工智能研究热点及趋势分析. 中国医药导报. 2024(25): 191-196 .  百度学术

百度学术

4. 康文文,韩贺东,吕镗烽,宋勇. 精准医疗时代下肺癌筛查的难点与对策. 中华结核和呼吸杂志. 2024(12): 1211-1216 .  百度学术

百度学术

其他类型引用(1)

下载:

下载: