Low-dose CT Denoising Based on Subspace Projection and Edge Enhancement

-

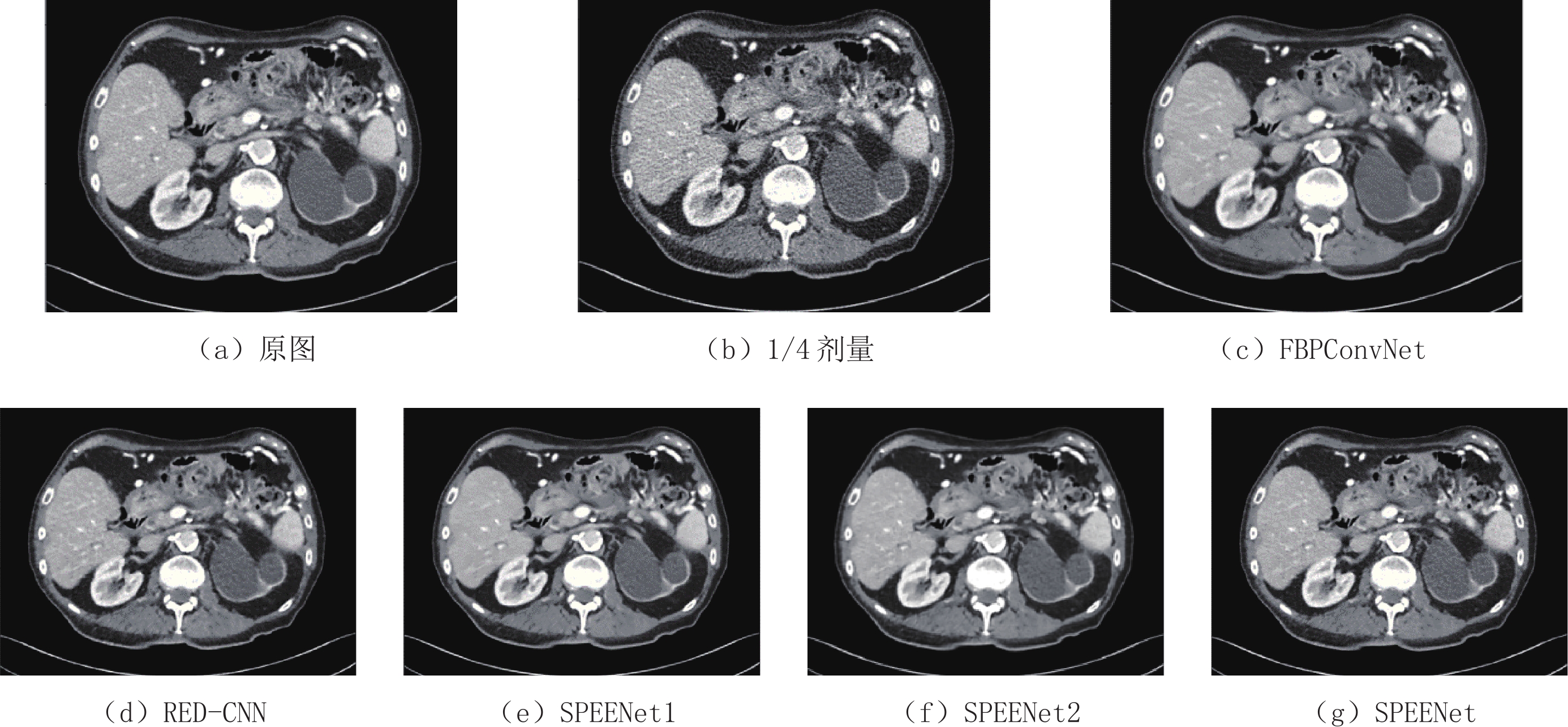

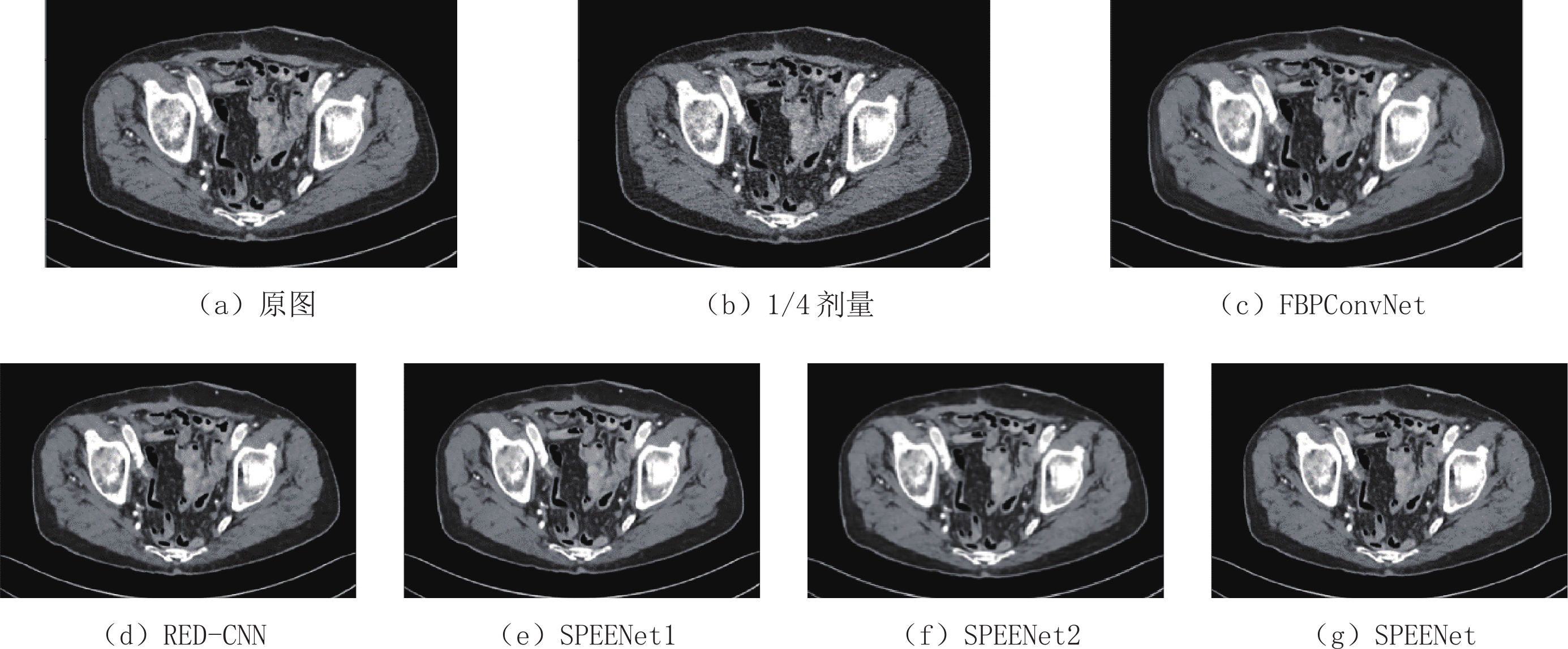

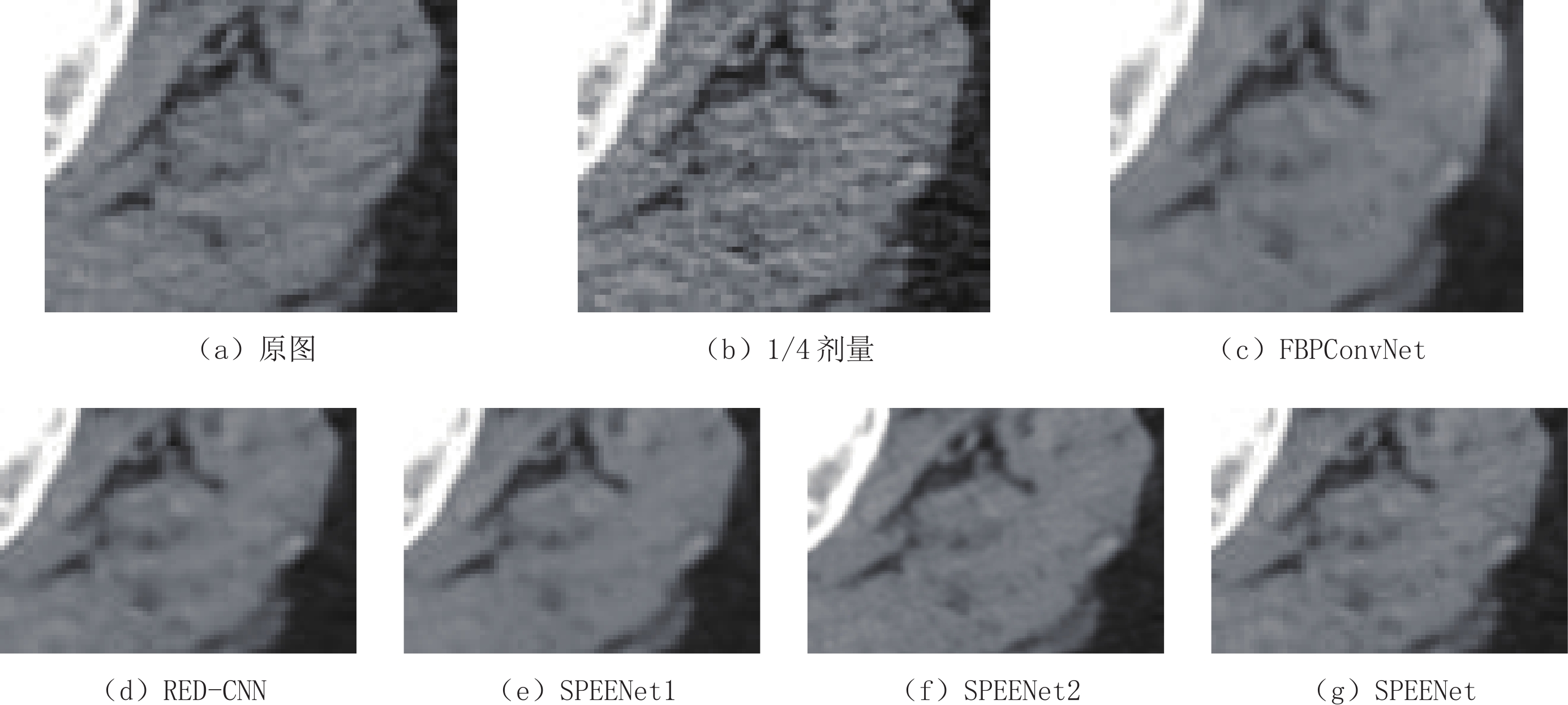

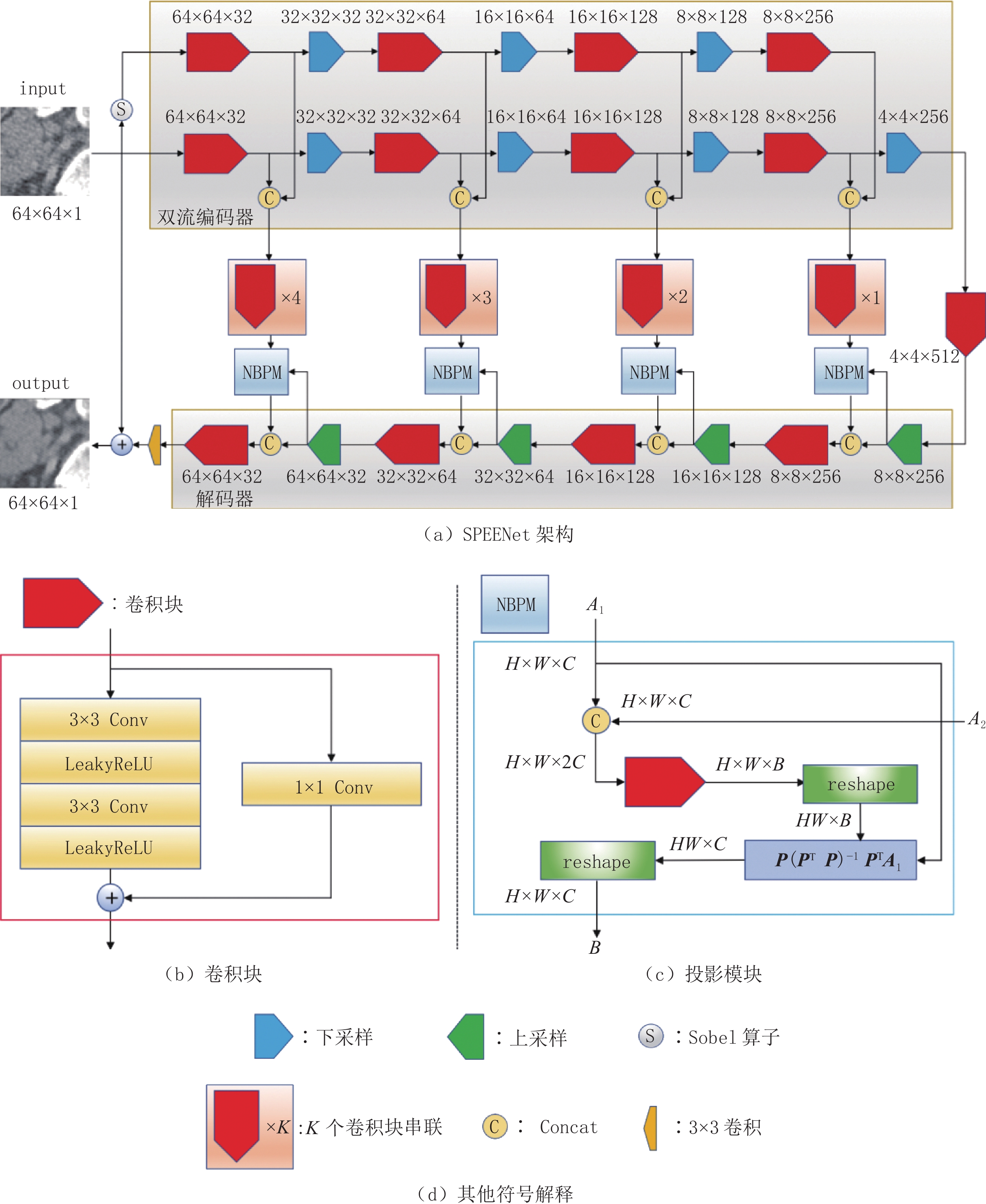

摘要: 低剂量计算机断层扫描(CT)是一种相对安全的疾病筛查手段,但低剂量CT图像往往包含较多噪声和伪影,严重影响医生的诊断。针对该问题,本文提出一种基于子空间投影和边缘增强网络(SPEENet)。SPEENet为自编码器结构,包含双流编码器和解码器两个主要模块。双流编码器可以被分为噪声图像编码流及边缘信息编码流两部分,噪声图像编码流对低剂量CT图像进行特征提取,利用图像特征去除低剂量CT中的噪声和伪影;边缘信息编码流部分主要关注低剂量CT图像的边缘信息,利用边缘信息保护图像结构。为充分利用编码器特征,本文引入噪声基投影模块,构建基于编码器和解码器特征的基,并利用该基将编码器提取的特征投影到对应的子空间,获取更好的特征表示。本文在公开数据集上进行实验以验证提出网络的有效性,实验结果表明,相较于其他低剂量CT去噪网络,SPEENet可以取得更好的去噪效果。Abstract: Low-dose computed tomography (CT) is a relatively safe method for disease screening. But low-dose CT images often contain severe noise and artifacts, which seriously affect the subsequent diagnosis. To solve this problem, this paper proposes a subspace projection and edge enhancement network (SPEENet). SPEENet hold an architecture of autoencoder, including two main modules: dual stream encoder and decoder. The dual stream encoder can be divided into two parts: noise image coding stream and edge information coding stream. The noise image coding stream removes the noise and artifacts in low-dose CT images by using the image features extracted from the low-dose CT images. The edge information coding stream mainly focuses on the edge information of low-dose CT images and fully utilize the edge information to preserve the structures. In order to make full use of the encoder features, this paper introduces the noise basis projection module to establish a basis based on the features of encoder and decoder, and uses this basis to project the features extracted by the encoder into the corresponding subspace to obtain better feature representation. In this paper, experiments are conducted on the public database to verify the effectiveness. The experimental results show that SPEENet can achieve better denoising performance than other low-dose CT denoising networks.

-

Keywords:

- deep learning /

- autoencoder /

- low-dose CT /

- subspace projection /

- edge information

-

-

表 1 去噪结果的PSNR和SSIM

Table 1 PSNR and SSIM of the denoised results

方法 FBPConvNet RED-CNN SPEENet1 SPEENet2 SPEENet PSNR 32.104 32.731 33.204 33.233 33.072 SSIM 0.919 0.916 0.920 0.922 0.923 -

[1] PAN X, SIDKY E Y, VANNIER M. Why do commercial CT scanners still employ traditional, filtered back-projection for image reconstruction?[J]. Inverse Problems, 2009, 25(12): 123009. doi: 10.1088/0266-5611/25/12/123009

[2] WANG J, LI T, LU H, et al. Penalized weighted least-squares approach to sinogram noise reduction and image reconstruction for low-dose X-ray computed tomography[J]. IEEE Transactions on Medical Imaging, 2006, 25(10): 1272−1283. doi: 10.1109/TMI.2006.882141

[3] MANDUCA A, YU L, TRZASKO J D, et al. Projection space denoising with bilateral filtering and CT noise modeling for dose reduction in CT[J]. Medical Physics, 2009, 36(11): 4911−4919. doi: 10.1118/1.3232004

[4] XU Q, YU H, MOU X, et al. Low-dose X-ray CT reconstruction via dictionary learning[J]. IEEE Transactions on Medical Imaging, 2012, 31(9): 1682−1697. doi: 10.1109/TMI.2012.2195669

[5] ZHENG X, RAVISHANKAR S, LONG Y, et al. PWLS-ULTRA: An efficient clustering and learning-based approach for low-dose 3D CT image reconstruction[J]. IEEE Transactions on Medical Imaging, 2018, 37(6): 1498−1510. doi: 10.1109/TMI.2018.2832007

[6] FERUGLIO P F, VINEGONI C, GROS J, et al. Block matching 3D random noise filtering for absorption optical projection tomography[J]. Physics in Medicine & Biology, 2010, 55(18): 5401.

[7] MA J, HUANG J, FENG Q, et al. Low-dose computed tomography image restoration using previous normal-dose scan[J]. Medical Physics, 2011, 38(10): 5713−5731. doi: 10.1118/1.3638125

[8] CHEN H, ZHANG Y, KALRA M K, et al. Low-dose CT with a residual encoder-decoder convolutional neural network[J]. IEEE Transactions on Medical Imaging, 2017, 36(12): 2524−2535. doi: 10.1109/TMI.2017.2715284

[9] SHAN H, ZHANG Y, YANG Q, et al. 3-D convolutional encoder-decoder network for low-dose CT via transfer learning from a 2-D trained network[J]. IEEE Transactions on Medical Imaging, 2018, 37(6): 1522−1534. doi: 10.1109/TMI.2018.2832217

[10] YOU C, LI G, ZHANG Y, et al. CT super-resolution GAN constrained by the identical, residual, and cycle learning ensemble (GAN-CIRCLE)[J]. IEEE Transactions on Medical Imaging, 2019, 39(1): 188−203.

[11] GHOLIZADEH-ANSARI M, ALIREZAIE J, BABYN P. Deep learning for low-dose CT denoising using perceptual loss and edge detection layer[J]. Journal of Digital Imaging, 2020, 33(2): 504−515. doi: 10.1007/s10278-019-00274-4

[12] ZHANG K, ZUO W, CHEN Y, et al. Beyond a gaussian denoiser: Residual learning of deep CNN for image denoising[J]. IEEE Transactions on Image Processing, 2017, 26(7): 3142−3155. doi: 10.1109/TIP.2017.2662206

[13] AWAR S, BARNES N. Real image denoising with feature attention[C]//IEEE/CVF International Conference on Computer Vision. 2019: 3155-3164.

[14] GUO S, YAN Z, ZHANG K, et al. Toward convolutional blind denoising of real photographs[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition, 2019: 1712-1722.

[15] ZAMIR S W, ARORA A, KHAN S, et al. Learning enriched features for real image restoration and enhancement[C]//European Conference on Computer Vision. Springer, Cham, 2020: 492-511.

[16] CHENG S, WANG Y Z, HUANG H B, et al. NBNet: Noise basis learning for image denoising with subspace projection[C]//IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 4896-4906.

[17] HUANG Z, ZHANG J, ZHANG Y, et al. DU-GAN: Generative adversarial networks with dual-domain U-Net based discriminators for low-dose CT denoising[J]. arXiv Preprint. arXiv: 2108.10772, 2021.

[18] SHAN H, PADOLE A, HOMAYOUNIEH F, et al. Competitive performance of a modularized deep neural network compared to commercial algorithms for low-dose CT image reconstruction[J]. Nature Machine Intelligence, 2019, 1(6): 269−276. doi: 10.1038/s42256-019-0057-9

[19] LUTHRA A, SULAKHE H, MITTAL T, et al. Eformer: Edge enhancement based transformer for medical image denoising[J]. arXiv Preprint. arXiv: 2109.08044, 2021.

[20] KANOPOULOS N, VASANTHAVADA N, BAKER R L. Design of an image edge detection filter using the Sobel operator[J]. IEEE Journal of Solid-state Circuits, 1988, 23(2): 358−367. doi: 10.1109/4.996

[21] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]//IEEE Conference on Computer Vision and Pattern Recognition. 2016: 770-778.

[22] XU B, WANG N, CHEN T, et al. Empirical evaluation of rectified activations in convolutional network[J]. arXiv Preprint. arXiv: 1505.00853, 2015.

[23] LIU J, HU Y, YANG J, et al. 3D feature constrained reconstruction for low-dose CT imaging[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2016, 28(5): 1232−1247.

[24] LIU J, MA J, ZHANG Y, et al. Discriminative feature representation to improve projection data inconsistency for low dose CT imaging[J]. IEEE Transactions on Medical Imaging, 2017, 36(12): 2499−2509. doi: 10.1109/TMI.2017.2739841

[25] CHEN Y, SHI L, FENG Q, et al. Artifact suppressed dictionary learning for low-dose CT image processing[J]. IEEE Transactions on Medical Imaging, 2014, 33(12): 2271−2292. doi: 10.1109/TMI.2014.2336860

[26] YIN X, ZHAO Q, LIU J, et al. Domain progressive 3D residual convolution network to improve low-dose CT imaging[J]. IEEE Transactions on Medical Imaging, 2019, 38(12): 2903−2913. doi: 10.1109/TMI.2019.2917258

[27] LYU T, ZHAO W, ZHU Y, et al. Estimating dual-energy CT imaging from single-energy CT data with material decomposition convolutional neural network[J]. Medical Image Analysis, 2021, 70: 102001. doi: 10.1016/j.media.2021.102001

[28] JIN H, MCCANN M T, FROUSTEY E, et al. Deep convolutional neural network for inverse problems in imaging[J]. IEEE Transactions on Image Processing, 2017, 26(9): 4509−4522. doi: 10.1109/TIP.2017.2713099

[29] MCCOLLOUGH C, BARTLEY A C, CARTER R E, et al. Low-dose CT for the detection and classification of metastatic liver lesions: Results of the 2016 low dose CT grand challenge[J]. Medical Physics, 2017, 44(10): e339−e352. doi: 10.1002/mp.12345

[30] KINGMA D P, BA J. Adam: A method for stochastic optimization[J]. arXiv Preprint. arXiv: 1412.6980, 2014.

-

期刊类型引用(3)

1. 郭杰,蔡爱龙,王少宇,郑治中,李磊,闫镔. 光子计数探测器投影数据噪声的p-范分布统计分析. 光学学报. 2024(03): 102-110 .  百度学术

百度学术

2. 杨光,高嘉保,韩瑞. 基于深度学习建立模型去除工业CT伪影的技术研究. 无损探伤. 2023(03): 18-22 .  百度学术

百度学术

3. 丰川. 多层螺旋CT双低剂量扫描在冠状动脉血管成像诊断冠心病中的应用价值. 影像研究与医学应用. 2023(13): 87-89 .  百度学术

百度学术

其他类型引用(2)

下载:

下载: